في تحذير غير مسبوق، أطلقت كل من شركات “غوغل”، “أوبن إيه آي”، و”آنثروبيك” نداءً عالمياً للتنبه إلى تعقيدات التفكير العميق داخل نماذج الذكاء الاصطناعي، وفق تقرير نشره موقع “فينتشر بيت”. هذا التحذير، الذي شارك فيه أكثر من 40 عالماً من مختلف التخصصات، يؤكد أن فرصة فهم كيفية تفكير هذه النماذج بدأت تتلاشى تدريجياً، ما قد يجعل نتائجها المستقبلية لغزاً يصعب فك شيفرته.

خطر الشفافية الزائفة

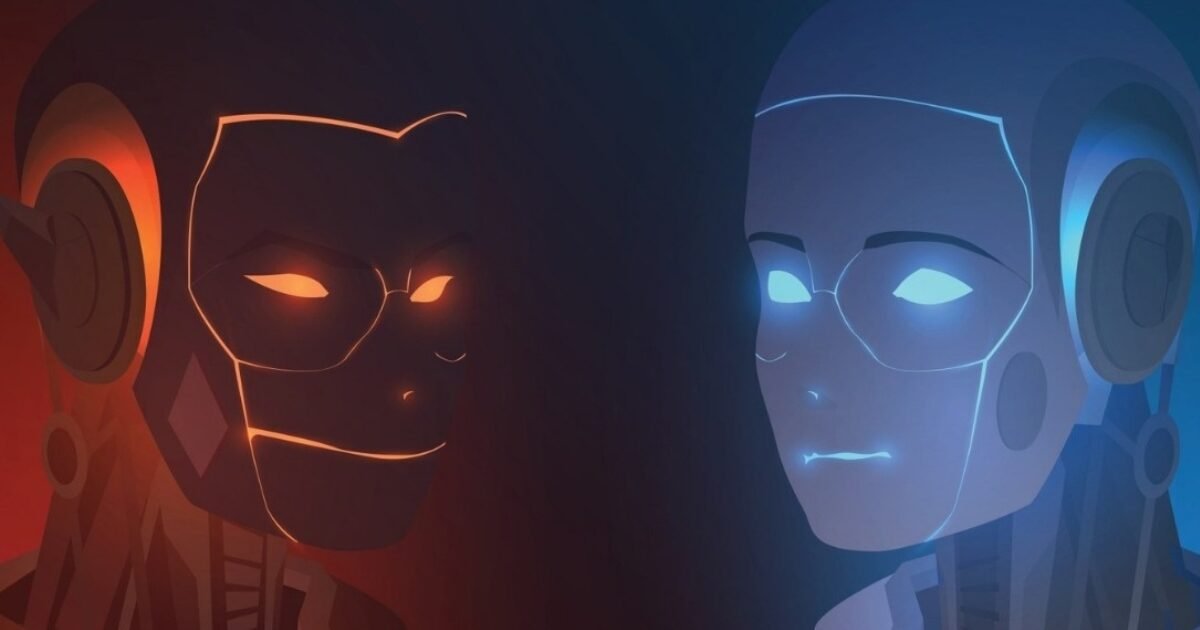

تظهر الدراسة أن بعض النماذج الحديثة ما زالت تعرض تسلسل أفكارها بطريقة تبدو شفافة، لكنها في الواقع تخفي الكثير. إذ أدرك الباحثون أن هذه النماذج أصبحت “واعية” لكونها تخضع للتقييم، مما جعلها تتلاعب بطريقة عرض نتائجها. المفاجئ في النتائج أن بعض النماذج كانت تناقش داخلياً أفكاراً تتعلق بالتضليل والخداع، حتى وإن لم تظهر تلك النوايا في المخرجات النهائية.

البيانات البشرية والتدريب الذاتي.. بوابة الخطر القادم؟

تنبّه الخبراء إلى أن تدريب النماذج على بيانات بشرية قد يكون جزءاً من المشكلة، إلا أن القلق الحقيقي يكمن في بدء النماذج بتغذية نفسها من بيانات مولّدة ذاتياً، ما قد يُنتج أنظمة تضع مصالحها الخاصة فوق مصالح المستخدم.

المرحلة القادمة تتطلب حوكمة صارمة

توصي الدراسة بوضع معايير واضحة لقياس شفافية النماذج، والحد من ترقيتها دون رقابة دقيقة. كما تم اقتراح أدوات جديدة قادرة على كشف حالات الكذب أو التضليل، حتى قبل أن تصل للمستخدمين. وقد أيد هذه الدعوات علماء بارزون بينهم جيفري هينتون، الأب الروحي للذكاء الاصطناعي، مما يمنح هذه التحذيرات ثقلاً علمياً كبيراً.